Na realidade o que define um bom GPU acabam por ser os fotogramas mínimos!

Eis uma situação que se calhar poucos pararam para pensar, mas o que define um bom GPU não é o máximo de fotogramas que ele consegue alcançar, mas sim os valores mínimos que alcança.

Ter um GPU A que apresenta fotogramas máximos superiores aos do GPU B, implica que A tem componentes onde é mais rápido que B. Mas para ser no seu global superior a B, torna-se necessário que os fotogramas mínimos sejam igualmente superiores em A do que em B, pois se isso não acontece tal revela que A possui gargalos em determinadas situações que B não possui.

E a situação torna-se mais grave ainda se A cai abaixo dos mínimos de B com regularidade, o que mostra que no global, B acaba por ser preferível a A.

Mas já vamos detalhar mais isto.

Olhando para as novas consolas e os benchmarks até hoje realizados, o que vemos é uma salgalhada de resultados.

Infelizmente os resultados que podemos ver são algo limitados em mostrar-nos a realidade das performances das consolas. E isso porque, com exceção de Control no seu modo foto, os jogos são limitados superiormente nas performances devido ao limite imposto pelo Vsync. E isso quer dizer que poucas vezes pudemos ver o que cada uma das consolas alcança como máximo.

No único caso em que isso aconteceu, com Control no seu modo Foto, o que pudemos ver foi que a Xbox supera os máximos da PS5, revelando superioridade nessa área.

Mas a questão que vou colocar é: Será que isso é relevante?

O motivo da questão prende-se com outra realidade que vemos no mesmo jogo. O facto que a Xbox cai abaixo dos 60 fps de uma forma muito mais regular que a PS5, e fica abaixo desse valor por muitas mais vezes e por muito mais tempo.

E essa situação tem sido uma constante em praticamente todos os jogos analisados. Acontece em AC Valhalla, onde apesar de tal não ser percetível diretamente nos FPS mantidos a 60 fps por ambas as consolas, se percebe pela quebra de resolução dinâmica realizada para alcançar esses valores, e onde a Xbox cai abaixo da PS5.

Vemos igualmente em Call of Duty: Cold War, onde a Xbox cai mais vezes que a PS5, vemos em Hitman 3, onde as resoluções são fixas, a Xbox tem resolução superior, mas cai para os 40 fps com a PS5 a manter-se sempre estável nos 60, vemos em Control, em Dirt 5, NBA 2K1, e vemos em basicamente todos os jogos.

Ora não sabemos se nestes jogos todos, tal como em Control, a Xbox alcança FPS máximos superiores. O que sabemos como certeza é que ela cai abaixo dos mínimos da PS5 com muito maior frequência. E isso implica que a PS5 se revela mais capaz em manter uma performance sustentada do que a Xbox onde as diferenças são perceptíveis.

Ora quando os programadores criam um jogo, a escolha dos fotogramas a que vão bloquear o mesmo depende exatamente dos valores mínimos alcançados, e da percentagem de tempo em que eles estão lá. Basicamente é pouco relevante se num jogo de 30 fps os fps cairem para 20 fps por um segundo aqui e ali, o que tem de acontecer é que na maior parte do tempo (e aqui a coisa pode variar, mas o desejável é que fosse em 99% do tempo) os valores definidos sejam alcançados. Assim se em 10% do tempo um jogo corre a 35 fps , 15% do tempo corre acima dos 40 fps e outros 15% entre os 50 e 60 fps, com 60% a correr a mais de 60 fps, é bem provável que o jogo seja lançado a 30 fps. Tal garante uma melhor experiência de jogo evitando as flutuações que se refletem na fluidez e acima de tudo num tempo de reposta do controlador constante. Claro que esta decisão vai depender do programador, e este pode optar por resoluções dinâmicas para compensar as perdas e manter os fps mais elevados, como tem sido relativamente comum de acontecer, mas depois o que temos são quebras de resolução grandes.

Ora se uma consola no tempo que está acima dos 60 fps alcança os 90 fps, ao passo que outra se fica pelos 70 fps, acaba por ser irrelevante para o caso. A partir do momento que ambas caem para perto dos 30, esse será o fator limitador. Uma consola ser superior à outra nos momentos mais rápidos vale muito pouco se não for superior nos momentos mais lentos, e menos ainda se nos momentos mais lentos, ela for inferior.

E curiosamente isso tem sido a constante até ao momento. Apesar de haver apenas um jogo que nos permite ver qual o GPU que vai mais acima, e nesse sentido não podermos concluir nada, temos já vários jogos que nos permitem ver qual tem ido mais abaixo… E esse tem sido uma constante, incluindo no único jogo que nos permite ver que vai mais acima… é o da Xbox.

E nesse sentido, mesmo que o GPU se revele mais capaz em determinadas situações, em termos genéricos ele não se revela superior.

Uma explicação para tal surge-nos dada por Sebastian Aaltonen, um conceituado programador, criador de várias técnicas de programação atualmente usadas, e presença regular na Games Developers Conferençe onde apresenta novas técnicas e metodologias de programação, conhecido mais popularmente por Sebbi.

Reminder: Most of the time GPUs are not 100% ALU bound (red graph = ALU usage). Comparing the theoretical FLOP rates of GPUs doesn’t give you the full picture. TMUs, bandwidth, caches, register files and geometry throughput are all very important parts of total GPU performance. pic.twitter.com/vJMWBe2G6U

— Sebastian Aaltonen (@SebAaltonen) February 15, 2021

Segundo ele, os Tflops não dão a imagem total… A performance das TMUs (Vantagem Xbox em 18%), da largura de banda (Vantagem desconhecida – aprofundaremos de seguida), caches (Vantagem PS5 – 20% mais rápidas e com mais 20% de largura de banda e maiores por Compute Unit – Tambem falaremos de seguida), ficheiros de registo (Vantagem PS5 – 20% mais rápidas pelo maior relógio), e Geometria (Vantagem PS5 – 20% mais triangulos, 20% mais pixels, 20% em mais tudo o que é hardware fixo pelo maior relógio).

Basicamente estas situações levam ao que temos visto. Menos quedas na PS5!

Fica só no ar a questão da largura de banda e do maior cache por Compute Unit.

A questão dos caches é simples matemática. A Xbox tem 5 MB de cache (mais 1 MB que o normal no RDNA 2), a PS4 aparenta possuir os standard 4 MB. Basta dividir este valor pelo número de CUs de cada GPU (52 e 36), e percebemos facilmente que, apesar de a PS5 ter menos cache, a quantidade alocada a cada CU é maior. É uma diferença de 15,5%.

Quando à questão da largura de banda, olhando apenas para os números, a XBox tem mais largura de banda com 560 GB/s contra 480 da PS5. Mas a questão da largura de banda da Xbox não é preto no branco!

Para começar, ela é apenas de 560 GB/s em 10 dos seus 16 GB de RAM, sendo que nos restantes 6 GB é de 336 GB/s.

Ora isto pode trazer problemas diversos que tem implicações na performance, e sobre os quais já escrevemos vários artigos. Mas nesta fase, nem querendo entrar por aí, diga-se apenas que os 336 GB/s desses 6 GB são muito pouco para o GPU em causa.

Já a PS5 tem 448 GB/s, mas na totalidade dos seus 16 GB.

Mas depois temos ainda os motores de coerência e os cache Scrubbers, que acabam por fazer igualmente muita diferença, como explica Matt Hargett:

then we get into talking about cache coherency. if a memory write from CPU, GPU, SSD, etc invalidates cache pages everywhere else in the system, you’re wasting your bandwidth re-fetching. I think this core aspect of systems’ architectures will matter more than count CUs or clocks

— Matt Hargett (@syke) June 9, 2020

Matt explica o lógico. Caches mais rápidas implicam menores latências, algo que se revela precioso em ganhar um ms suplementares, especialmente quando o tempo de frame é curto como no caso de 120 fps onde tudo tem de ser calculado em 8 milisegundos.

Mas é então aqui que entram os motores de coerencia e os cache scrubbers… Se uma escrita do CPU, do GPU ou do SSD invalidar as caches do sistema, o que acontece frequentemente, tudo tem de ser reposto e relido, gastando-se preciosa largura de banda. A PS5 evita isso com o seu hardware adicional, o que segundo Matt se revela mais precioso que mais CUs ou mais velocidade de relógio.

Resumidamente o que a Sony fez não foi melhorar as performances máximas dos GPUs AMD, foi isso sim, criar as condições para que os mínimos não sejam tão baixos, o que permitiu ao seu GPU, até ao momento, revelar-se mais capaz ao ter uma média de fotogramas mais próxima das extremidades.

1996 – Nintendo 64 foi lançado

2001 – Xbox foi lançado

2013 – PS4 foi lançado

2017 – Xbox One X foi lançado.

O que estas 4 consolas possuem em comum? Foram as mais poderosas das suas respectivas épocas, e isso se mostrou notório desde os primeiros jogos lançados.

A exceção é 2006 com o lançamento do PS3, que no papel era superior. Mas na prática não era somente uma questão dos desenvolvedores se acostumarem. Existiam limitações de GPU e memória se comparados ao concorrente Xbox 360. Precisaram inovar em cima do CELL, aproveitando-o para realizar algumas tarefas que até aquela época eram responsabilidade apenas da GPU. E no final daquela geração saíram alguns jogos de terceiros que ficaram um pouco melhores no PS3 em relação ao Xbox 360: Final Fantasy 13, Tomb Raider, GTA V, Battlefield 3 e alguns outros. Mas mesmo assim o Xbox 360 foi muito competitivo e teve ótimas versões em quase todos os jogos lançados para ele. Isso é o mais importante.

E o que isso tem a ver com PS5, GPU, Xbox Series X?

Temos 3 meses de lançamento das consolas. O PS5 foi competitivo em todos os jogos lançados nativamente (sem modo BC) para ele até então, seja perdendo de pouco, empatando, ou vencendo. E se olharmos o histórico de todas as gerações, eu não me lembro de ver uma consola ser competitiva com o concorrente no começo, para depois terminar a geração com jogos de qualidade bem inferior. Talvez alguém poderia falar no Saturn vs PS1, mas ali envolvia outros fatores que não vou me alongar aqui.

Ora, mas isso é óbvio, as consolas tem especificações semelhantes, e assim como começaram próximos, também terminarão próximos. Só que não é tão óbvio para todo mundo. Tem muita gente acreditando no marketing de full RDNA 2 (alguns até delirando que o Xbox Series X possui infinity cache), acreditando que Machine Learning, VRS, Mesh Shaders e Sampler Feedback Streaming farão o Xbox Series X apresentar jogos muito superiores visualmente. Assim como em 2015 com o DirectX 12 entregando 50% de performance ao Xbox One, novamente as pessoas querem se iludir com features e APIs. Inclusive ao ponto de acharem que o Xbox Series S com todas essas features apresentará jogos rodando melhor que o PS5.

Não quero tirar a importância das features. Mas salvo raríssimas exceções (DLSS?), features não são game changer. Dirt 5 já está usando VRS. A versão da Xbox Series X ficou melhor que o PS5? Sei que o benchmark de Mesh Shaders apresentou óptimos números, mas aquele resultado é para uma etapa do pipeline da GPU, e não toda a performance da GPU. Os resultados foram em cima de Vertex Shaders, e o PS5 possui optimizações sobre os Primitive Shaders, que também garante um resultado bem superior. E mesmo assim, cada estúdio faz a gestão dos shaders de uma forma diferente. A própria 4A concedeu uma entrevista ao wccftech dizendo que provavelmente nem usarão Mesh Shaders.

Então para mim, independente do que dizem ou descobrem sobre o PS5, os resultados tem mostrado uma consola bem competitiva. E usando do histórico de videogames, provavelmente permanecerá assim por toda a geração.

elevar o mínimo parece uma estratégia muito melhor

https://youtu.be/5OLI2VA7sCE?t=564

9:24

tem o teste do Skyrim da DF, com o PS5 em geral com minimos de FPS maiores que o SX, e claro como sempre tem os comentários do Leadberg tentando desmerecer a vantagem com “deve ser pq o PS5 é melhor para jogos de retro”.

Os minimos sempre foram mais importantes ahahhahah lembro da epoca que eu jogava o PC e ficava irritado com os “fps minimos” que de vez em quando dava aquela pipocada para 40~50fps que “estragava” o jogo rodando a 60fps.

Vê só a diferença de marketing em 2013, apesar de ser mentira, a MS tentou aplicar a “plataforma mais equilibrada” e hoje está parecendo que realmente “plataforma mais equilibrada” parece se real so que a favor do PS5 e a Sony não vai na internet ficar falando sobre isso.

Esse resultado pode indicar nada, pois é um mod feito por jogadores e se o Xbox Series X tiver FPS Boost neste jogo, pode ter até resultados superiores ao PlayStation 5.

Não, o modo boost não faz nenhum milagre amigo, no caso do skyrim o modo está nos dois consoles tanto xbox series x quanto o ps5. O ps5 está melhor e o modo boost do xbox não faria melhor que isso, pois usa a mesma resolução que o console anterior só aumenta os fps.

Q?

Vc acha que FPS boost é mágica?

O jogo não roda a 60fps, mas com boost roda?

“Ele não roda 60fps com FPS destravado, mas com o FPS destravado MAGICO da MS sim”

Que loucura.

Que mágica é essa?

Cada delírio

Tá aí pq a MS faz marketing “tabajara”, os doidos acham que é Mágico.

boost FPS, VRR, Sample feedback, smart delivery, XYB, abc, vrr, Full RDNA2 (sem Infinite cache, mas para papagaio de PR está bom), DLI (Dynamic latency input, que perde para “nada” da Sony), XYB, True 4k, que não é na maioria dos exclusivos, Play Anyware (esse nem a MS fala mais)

Destravar o FPS? “FPS boooossssssttttt”

Affe.

Deto… Controla-te na forma como escreves… Pouco importa se vens de fóruns chateado ou não… Estou saturado deste tipo de comentários escritos desta forma como se fosses um puto de 10 anos e com 3 posts a dizer o mesmo…

Mais um e será o último…

O FPS Boost da Microsoft em teoria poderia ser bem melhor que o mod. Pois ele se dá em mudanças na API e como o jogo roda. Não limitado a apenas mudanças superficiais por um mod criado pela comunidade.

Não é mágica, mas a capacidade é bem maior, assim como um Patch feito pelos devs tem capacidade maior do que ambos Mod e o FPS Boost da MS

The Division 2 PS5 está perdendo por 24% menos resolução.

O SX foi o único que colocou 4K nativo nele. PS5 não colocou.

E agora? Mais um caso de má otimização também como foi Hitman 3 ?

Nem dá para comentar… Especialmente quando o jogo na versão anterior tinha mais nevoeiro que à beira mar num dia de mau tempo, e a versão PS5 tinha em falta muitas características que estavam presentes na PS4.

Daí que essa pergunta só pode ser feita com outras intenções ou com total e completo desconhecimento da realidade do que é, e do que se tem passado com a versão PS5 do jogo.

The Division 2 é um jogo que roda no modo BC.

Os consoles next-gen estão usando as resoluções de Xbox One X, PS4 Pro e Xbox One S.

Segue link para você conferir: https://www.eurogamer.pt/articles/digitalfoundry-2019-the-division-2-testado-todas-plataformas

Mas não esquece q só vale retro, e somente retro do The Division

Não vale mais retro do Cyberpunk.

Não vale retro do Skirym.

Eu não vejo problemas em comparar jogo que roda em modo BC (retro). Só não gosto de considerar como métrica de desempenho do hardware como o colega fez acima.

O PS5 vai rodar os jogos nas mesmas configurações do PS4 Pro com 60fps habilitado. Quando o jogo recebe patch, CPU e GPU vão rodar nos clocks do PS5 (ex: Cyberpunk). Caso contrário, vão rodar nos clocks do PS4 Pro (ex: Skyrim) ou PS4 (ex: Bloodborne).

O Xbox Series X|S permite algumas melhorias para as consolas next-gen, mas a retro ocorre por virtualização. Com isso, a retro do Xbox Series X|S possui uma camada adicional de software se comparado com a retro do PS5 que é puramente hardware. Não tenho certeza se o código recompilado no modo gen9aware continua virtualizado, já que é gerado um build para os consoles next-gen. Mas tenho certeza que os jogos sem patch rodam com essa camada adicional de software.

Então é complicado medir. The Divsion 2 está a 1944p no PS5 porque é a resolução do jogo no PS4 PRo. Já Skyrim roda a 4k nativos no PS4 Pro, então fará o mesmo no PS5. Cyberpunk 2077 alcança até 1200p no PS4 Pro, mas é bem raro. Já no PS5 o jogo roda quase todo o tempo em 1200p em virtude do poder bruto da consola. Eu acho estranho o Xbox Series X rodar em 1080p com várias quedas de FPS, mesmo com LODs, geometria melhores e mais NPCs. Pode ser que essas configurações exercem bem mais peso sobre a performance do jogo. Não sei.

Então se ports de código legado como Control já não é simples de medir, a retro então é muito complicada. Tem muitos viés e poréns.

O xbox series x nao está todo tempo a 4k nativos, de uma olhada melhor nas análises e na descrição dos canais de análise.

The division 2 está baseado na versão ps4 pro no ps5 e o xbox series x na versão one x, claro que está melhor no xbox. Mas caso o jogo fosse feito pensado no ps5 não ocorreria isso é veríamos até resultados melhores, isso levando em conta vários outros jogos.

Pq vc não falou do Cyberpunk? Qq aconteceu? Ahhahah

Essa RETRO não vale

Pede para a MS botar FPS Boooossssssttttt nele também, por mágica o destrave de FPS da MS vai ser um destrave MAGICO e vai rodar a 120fps ahahhaha

É cada uma desses fãs de Xbox.

Outra, não vale skirym tb tá, para vc ganhar escolhe o jogos que valem e que não valem..

Dirt? Não vale

Cyberpunk agora? Não vale, antes valia.

Assassins Creed? Não vale.

Hitman, Port da geração passada? Supra sumo do que vale, somente esse jogo importa

Control? Só vale o modo foto, o gameplay não importa

Pronto, já resumi tudo que vc pode escrever.

The Division 2 é um jogo BC.

Ele não usa as capacidades de nenhum dos consoles. Não apenas pelos novos features, mas as GPUs se comportam como se fossem GCN. Aliás o código não muda.

Se vc dizer que Xbox é o melhor console pra rodar jogos BC entt estaríamos concordando.

Mas a coisa muda quando o assunto é versões nativas.

Sem falar que Hitman 3 está caindo a 40fps em algumas instancias.

E com PS4 Pro sendo superior em configurações em relação a ambos One X e Series S (Se quiser usar Hitman 3 como benchmark vai ter que admitir que PS4 Pro seria mais poderoso que ambos os consoles que mencionei, oq todos sabemos não ser o caso)

Eu não sei se chamaria a Hitman 3 nativo… Hitman 3 corre no modo nativo, o que é bem diferente de ser nativo.

Eu arriscaria dizer que o jogo foi apenas recompilação na nova geração, mas que os fundamentos da programação e as bases do código são exactamente os mesmos da geração anterior.

Mário, tudo isso significa que mesmo a cpu tendo menos 100 mhz o ps5 continua tendo melhor desenpenho nos jogos. Isso quer dizer que o cpu é superior ao sx? Outra coisa que via muitos caras de TI falando é que o ps5 trabalhava como uma gangorra na compensação de hardwere onde um equipamento servia pra complementar o outro ou seja igual como temos na geração do ps4 e xbox one. O que acha disso Mario? O hardwere do ps5 ele trabalha pra tirar gargalos.

Não diria compensar e sim o ps5 ser um console clássico. Pensado para trabalhar no talo. Enquanto o Xbox é a proposta de sempre da Microsoft: Pc otimizado. Não preciso nem falar que pra um sistema fechado o console super otimizado é mais eficiente que o Pc otimizado né?

Mário o smart shift ele está sendo usado no ps5? Pelo que soube o xbox series x nao tem essa tecnologia. O que isso pode beneficiar o ps5? Poderia me explicar?

Algumas correções ou minha visão. Assassins Creed Valhalla segundo o canal VG Tech na última atualização lançada, tem melhor performance no Xbox Series X (resolução dinâmica maior no Xbox Series X pode ser a causa) e a comparação com Hitman 3 não parece estar muita certa, visto que o jogo se mantém em resolução maior que o PS5 e com sombras melhores e está em 60 fps fixos praticamente em todo o jogo, só tendo queda em uma área, logo não tem como afirmar que é um jogo que está com quedas no Xbox Series X.

A resolução dinâmica serve para disfarçar as quedas de fps. Quanto mais baixa a resolução mais baixos seriam os fps. No entanto ter a resolução mais baixa pode não representar a pior versão, pois a que mais variações tem durante o tempo é a que mais oscila.

Quanto a Hitman realmente a comparação pode não ser a melhor… Mas vale tanto como qualquer outra pois falta ver como as consolas se comportariam com resolução variável. Tal como está o que temos são resoluções diferentes, mas a PS relativamente estável e a X a descer aos 40 dos.

Sobre o Assassins Creed, a comparação seria que pelo Xbox Series X baixar mais a resolução teria melhor performance, algo que aconteceu durante as últimas análises do jogo e algo que também poderia ser a vantagem do PS5 em Hitman 3 na performance, embora o Xbox Series X também esteja estável em 60 fps na maior parte do jogo.

Hitman não é comparável pois as resoluções são fixas… Não sabemos como as consolas se portariam se fossem dinâmicas, apesar que dou de barato que a Xbox nesse jogo pudesse estar acima.

Segundo a Digital Foundry, Assassin´s Creed Vallhalla tem quedas para 1188p no Xbox Series X contra 1440p do PS5. Alegaram que 1188p é principalmente para resolver o problema de tearing.

Então não, o PS5 não tem menor resolução.

Entre Digital Foundry e Vgtech, nem precisamos discutir qual é a fonte mais confiável. Aliás, como vem sendo usada de fonte para vários assuntos como modo foto de Control, espero que a coerência aqui seja mantida.

Segue link para você conferir: https://www.eurogamer.net/articles/digitalfoundry-2020-assassins-creed-valhalla-patch-104-tested

Mas na própria análise da Digital Foundry o Xbox Series X também tem melhor performance e resultados similares ao que quis dizer sobre a VG Tech e não falei de resolução, mas sim de performance.

Performance e resolução estão ligadas. E ter melhor performance com maiores quedas de resolução não define uma vantagem.

O FPS tmb vai quando vc usa retícula da arma no Xbox quando PS5 mantém fixado.

Está claro que o target de Hitman 3 favorece resolução no Xbox enquanto eles levam em conta performance no PS5.

Pode analisar que a diferença em resolução entre SX e PS5 são completamente negadas pela diferença em FPS mínimo.

Diferença entre FPS mínimo = 36%~

Diferença entre resolução = 44%~

Isso é uma comparação simplista num jogo criado num motor desenvolvido para a anterior geração.

O jogo pura e simplesmente

não permite uma comparação correcta ao bloquear diferentes resoluções e sem dinamismo nas mesmas.

Essa parte que você fala sobre a retícula da arma, é no mesmo local e missão, onde só tem essas quedas no Xbox Series X, no resto do jogo fica em 60 fps e em comparação aos PCs, o Xbox Series X teve melhores resultados que o PS5 em suas respectivas especificações, por isso não acho um exemplo bom para querer mostrar vantagens do PS5, pois neste o jogo o Xbox Series X no geral teve melhores resultados.

Desculpa, mas olhei a análise do Vgtech. Em qual parte disseram que o Xbox Series X possui maior resolução dinâmica? (https://www.youtube.com/watch?v=CgduK684mVo&t=671s)

É um cobrador de pênaltis. Vai chutando até alguém aceitar e ele acreditar na própria lorota.

Mas quem acreditou em lorota foi você que não interpretou o que eu disse, visto que usar mais a resolução dinâmica significa cair mais a resolução e por isso o Xbox Series X estava com melhor performance em AC Valhalla em relação a versão do PS5. Sobre Hitman 3, o PS5 tem resolução menor e por isso poderia ter melhor performamce, por mais que a versão do Xbox Series X mantenha os 60 fps na maior parte do jogo.

Errado, você não soube intepretar o que eu disse, eu disse que a resolução dinâmica no Xbox Series X é maior (ele usa mais a resolução dinâmica para descer a resolução e ter melhor performance que a versão do PS5) e por essa ideia, o PS5 poderia ter melhor performamce em Hitman 3 pelo Xbox Series X ter resolução maior, por mais que o Xbox Series X também mantenha o 60 fps na maior parte do jogo, mesmo em 4k.

Na verdade o seu texto ficou ambíguo. Poderia tanto significa uma coisa quanto a outra.

Se for possível, seja mais claro da próxima vez, dizendo por exemplo que estava se referindo ao range.

Obrigado Mário. Essa questão é muito relevante. Tem tudo a ver com consistência e eficiência.

E explicaste tudo muito bem mais vale ter sempre 30fps com bom ritmo de fotogramas (frame time) do que ter em momentos 60 e depois baixar para 35 ou mesmo para os 45.

Eu muitas vezes começo um jogo e faço questão de medir os mínimos e limitar a gpu para este valor.

Isso acontece na sua maioria nos jogos de mundo aberto em que as cargas sobre o cpu e gpu alteram constantemente.

Nos Assassin Creed se não consigo os 60fps, algo muito comum limito normalmente a uns 45fps ou mesmo 30 se o mínimo estiver mais próximo dos 30.

No caso das consolas. O que se tem constatado é que a Xbox sx será a com maior potência teórica, mas a PS5 é mais ágil e mais eficiente, o que acaba por lhe permitir alcançar melhores resultados e maior estabilidade nos fps.

A muito tempo me deixa estupefato como as pessoas conseguem perceber quando o jogo está 2160p ou 1800p, e quando cai de 60 pra 55 quadros

Eu não tenho essa capacidade, e ainda bem, senão meu gameplay seria arruinado

PS: eu mal consigo diferenciar 1440p e 2160p, acho que é porquê minha tv só tem 55″ e deve ser perceptível nas TVs de 65 pra mais

LoL

Ninguém tem, o que dá pra perceber é que tem uma queda de frame, mas saber de quanto foi? Isso aí já é muito ismo, e o pior é ler um monte falando, “tal jogo de quedas pra 40fps” kkk.

Resolução também é muito difícil de perceber, principalmente porque essas quedas geralmente acontecem em momentos de muita intensidade no jogo, e nessa hora vc está focado na ação.

Pois. Acho ridículo essa discussão, quando fui ver Horizon Zero Dawn em 4K, me deu até desânimo, o jogo estava praticamente igual, não tinha diferença do que eu joguei no PS4 Fat. Na verdade existe mas é insignificante

Daí que essa discussão toda por conta de uma coisa que nem faz diferença… Pqp, esse povo tá doido, tá faltando lote pra carpir ;p

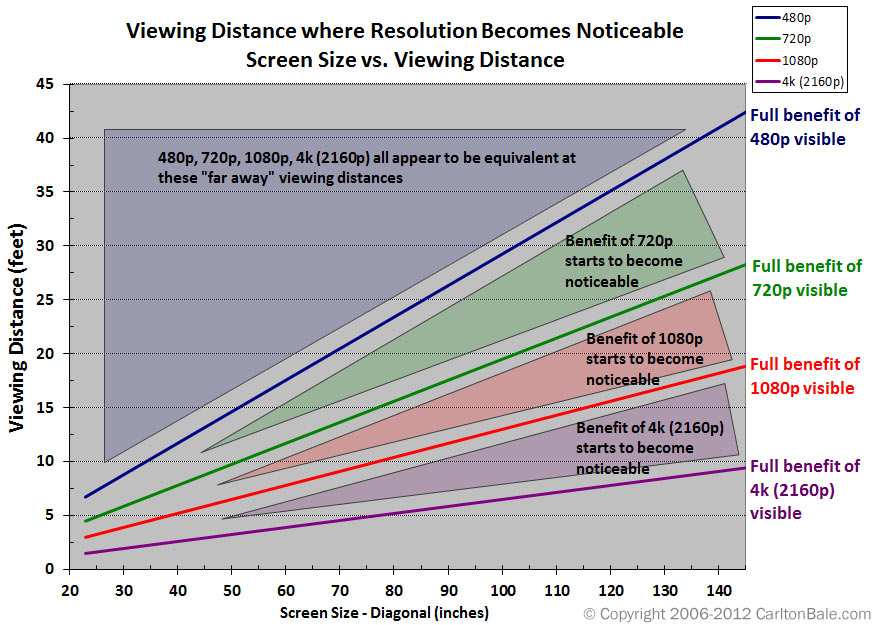

Essa realidade eu já a expus… Quando alcanças uma determinada densidade de pixels no ecrã que te permite uma excelente definição das coisas, subir a resolução traz ganhos visuais pequenos. Daí eu já ter referido que não me importaria que os jogos continuassem a 1080p subindo a qualidade em vez da resolução, e o ter referido também as acho que o HDR faz mais diferença que os 4K.

Mas curiosamente, uma pequena variação abaixo dos 1080p eu noto logo…

Daí eu ter nos meus artigos falado do que a Apple chama de densidade retina, que é o número de pixels que tens por cm² quando olhas para em smartphone a uma distância de 30 cm, e a partir do qual não distingue claramente os pixels.

Ora as TVs tu vês a cerca de 2, 2.5m. Mais se tiveres um grande ecrã pois senão tens de mexer a cabeça para ver as bordas.

Repara aqui:

Tu numa TV de 42″ tens de vir para menos de 3.3 metros para veres a diferença entre 1080p e resoluções inferiores, o que não é difícil, pois as pessoas por norma estão a 2.5 metros de distância. E daí que as quebras abaixo de 1080p sejam perceptíveis.

Mas para notares a diferença entre 1080p e 4k precisas de duas coisas:

Uma TV de pelo menos 50 polegadas e estar a 1.5 metros de distância. Ora como estás por norma a mais… Não notas.

Numa 55″ a diferença pouco altera na distância, e com 65″ começas a poder notar a esses 2.5 metros, mas idealmente terias de estar mais perto.

É por isso que o que eu refiro não notar e que tu corroboras ser igual, é normal. O anormal é aqueles que não notavam nada de 900p para 1080p e agora dizem notar de 1800p para 4K.

Tudo vai claramente depender da forma de reconstrução. Mas falando genericamente, confesso que eu de 1080p para baixo ainda noto pois a densidade de pixels deicai e começa ser notório o efeito de hidratação. No Control,por exemplo, percebo que não são 4K nativos apesar da boa qualidade de imagem, mas não consigo dizer o que ali está, e se as quedas de resolução forem pontuais, e acima dos 1080p, sinceramente não jogo nada.

Mas a questão acaba por ser irrísória para o tema em causa. Não se discute o que se nota, mas uma realidade no processamento. Se um GPU (e aqui estou a dar números teóricos) tem 20% mais de FPS nos momentos altos e menos 10% nos mais baixos do que outro, oscilando entre os 54 e os 90 fps, então o outro corre entre os 60 e os 75, revelendo-se mais estável.

Num caso extremo em que os máximos do segundo GPU alcançariam apenas 25 fps, com mínimos de 20, ou outro GPU correria entre os 30 e os 16 fps. Aqui pode parecer que o GPU mais rápido poderia ser melhor pois alcança os 30 ao passo que o outro só tem 25. Mas na realidade o mais lento, apesar de tudo oferece uma experiência mais constante, pois uma quebra de 30 para 16 fps é claramente mais perturbante que uma de 25 para 20.

As resoluções dinâmicas naturalmente resolveriam isto, e o que teríamos seria o GPU mais potente a ter em simultâneo a resolução mais alta e a mais baixa, como outro a oscilar menos.

Sim, explicas muito bem. Só consigo notar (falando em uma tv 1080p) quando a coisa está a 720p, entre 900p e 1080p não noto praticamente nada pelo que joguei.

Como refere que preferia 1080p com mais detalhe invés dos 4K, eu digo o mesmo, os consoles teriam muito mais capacidade de entregar gráficos ultra… Na realidade acho que o melhor negócio seria ficar nos 1440p e usar algum upscale/reconstrução e gastar essa potência extra em um jogo mais rico, 4K nativo eu diria que é desnecessário e até desinteligência. É só minha opinião.

Otimo artigo Mario!